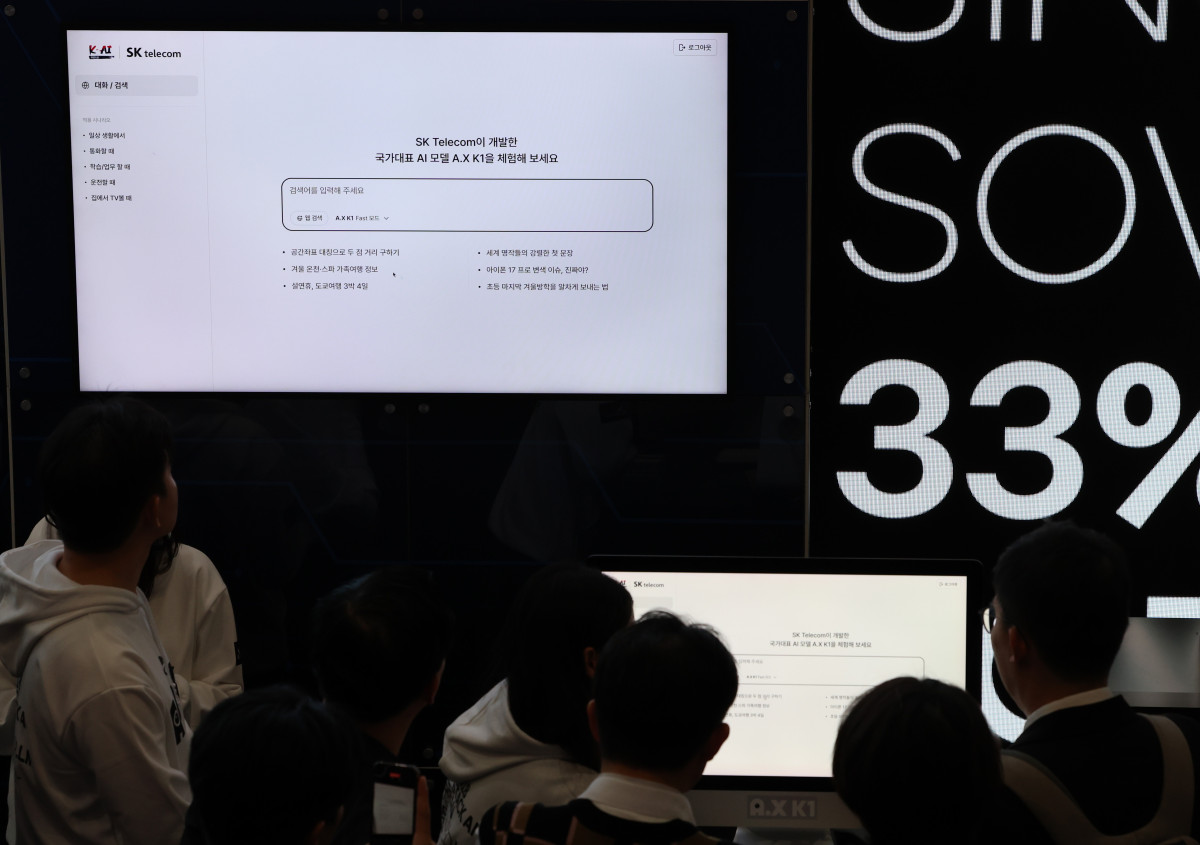

정부의 '독자 AI 파운데이션 모델 프로젝트'에 참여 중인 SK텔레콤 정예팀이 매개변수 519B(5190억 개) 규모의 초거대 AI 모델 ‘A.X K1’ 기술 보고서를 오픈소스 플랫폼 허깅페이스에 공개했다고 7일 밝혔다.

SKT 정예팀은 4개월 정도의 짧은 개발기간과 제한된 GPU 자원에도 불구하고 국내 첫 500B 이상 초거대 모델 A.X K1을 구현했다고 설명했다. A.X K1은 주요 벤치마크에서 '딥시크-V3.1' 등의 글로벌 초거대 모델과 유사하거나 더 높은 성능을 달성했다. 통상 매개변수가 많아질수록 최적화 시간과 GPU 자원 투입이 늘어나는데 타 정예팀 대비 2배 이상의 모델 규모임에도 높은 성능을 보였다는 점에서 주목된다.

SKT 정예팀은 519B 규모의 모델을 목표로 정하고 약 10조(10T) 개의 데이터를 투입해 학습했다. A.X K1 학습에는 1000개의 GPU 자원을 활용했다. 학습 기간과 GPU 규모를 바탕으로 가능한 총 학습량을 추산하고, 이를 바탕으로 최대 모델 크기를 스케일링 이론(모델 성능은 투입 자원에 비례한다는 이론)에 근거해 설계했다.

정예팀은 개발기간 동안 상시 1000개 이상의 GPU를 인공지능 훈련에 활용했다. 투여된 GPU 자원 대비 효과를 극대화하기 위해 최적의 학습 연산량을 수학적으로 설계하고 관리했다.

특히 이번 모델은 개발기간 동안 정부 지원을 받지 않고 자체 GPU 조달만으로 목표를 달성했다는 점에서 의미가 있다. 모델 학습에는 웹 데이터, 코드, 이공계 데이터, 추론 데이터 등 다양한 고품질 데이터를 활용했다. 한국어 특화 PDF 문서를 파싱해 합성 데이터를 생성했고, 난이도별 커리큘럼 학습 방식도 적용했다.

A.X K1은 수학과 코딩 등 초거대 인공지능 모델의 능력을 필요로 하는 분야에서 우수한 성능을 보였다. 미국 고등학생 수학 올림피아드 문제로 AI의 수학 실력을 측정하는 AIME25 벤치마크에서 89.8점을 받아 딥시크-V3.1 모델(88.4점) 대비 102% 수준으로 앞섰다.

코딩 활용 능력을 평가하는 라이브코드벤치(LiveCodeBench)에서는 영어 기반 75.8점, 한국어 기반 73.1점을 기록하며 실시간 코딩 문제 해결 능력을 입증했다. 영어 기반 69.5점, 한국어 기반 66.2점을 받은 딥시크-V3.1보다 점수가 높았다.

A.X K1은 전문가 혼합(MoE) 구조를 채택해 519B 규모의 파라미터 가운데 33B만 선택적으로 활성화하는 방식으로 효율성을 높였다. MoE는 여러 개의 작은 전문가 모델들이 모여서 하나의 큰 문제를 해결하는 방식으로 입력 데이터에 따라 가장 적합한 전문가가 선택돼 문제를 해결한다. 이와 함께 최대 128K 토큰의 긴 문맥을 처리할 수 있어, 한국어 기준 약 10만 단어 분량의 문서도 한 번에 분석할 수 있다.

A.X K1은 향후 추가 연구 기간에 따라 더 많은 컴퓨팅 자원과 데이터를 투입해 성능을 더욱 높일 수 있는 모델이다. SKT는 연내 멀티모달 기능을 추가하고 조 단위 파라미터로 확대할 계획이다.

![[단독] "넥슨 인수 안 한다”던 中 텐센트, 전략 수정…K게임 삼키기 ‘눈독’](https://img.etoday.co.kr/crop/140/88/2278578.jpg)

![평화롭다 vs 불편하다⋯'흰색' 하나에 심상찮은 말말말 [솔드아웃]](https://img.etoday.co.kr/crop/140/88/2279081.jpg)

![[테슬라 vs 엔비디아 1부] 엔비디아의 맹추격, 오히려 테슬라에겐 호재? AI 자율주행 최종 승자 말씀드립니다 ㅣ 강정수 블루닷AI 연구센터장 [찐코노미]](https://i.ytimg.com/vi/7R15ohHXNrg/mqdefault.jpg)

![삼성물산·hy 28년 연속 ‘업종 1위’ [2025 NCSI 결산]](https://img.etoday.co.kr/crop/85/60/2278773.jpg)

![올해 설 연휴도 일본여행 간다…한국인 가고시마·고베 수요↑ [데이터클립]](https://img.etoday.co.kr/crop/300/170/2279094.jpg)

!['2026 노사정 신년인사회' [포토]](https://img.etoday.co.kr/crop/300/190/2279136.jpg)