“국가대표 AI 자유롭게 검증해야”

“AI 검증 위한 독립적 벤치마크 필요”

수리적 추론 검증 ‘환각’ 줄여야

국내 AI 모델들 성능 개선 뚜렷

지난해 11월 대학수학능력시험이 끝난 뒤 생성형 인공지능(AI)에 수능 문제를 풀게 하는 시도가 이어졌다. GPT와 제미나이, 딥시크 등 글로벌 모델들은 예상대로 높은 점수를 기록했다. 그렇다면 우리나라에서 개발 중인 ‘국가대표 AI’의 성적은 어떨까. 궁금증은 있었지만 이를 직접 검증한 사례는 없었다.

김종락 서강대 수학과 교수팀이 국가대표 AI 개발 주관사 5곳의 AI 모델에게 수능 수학·논술 문제를 풀게 한 배경이다. 수학과 교수라는 이유로 수학 문제만 제시한 것은 아니다. 생성형 AI의 고질적 문제로 지적되는 ‘환각’ 현상을 줄이기 위해서는 수리적 추론 능력 검증이 필수적이라는 판단에서다.

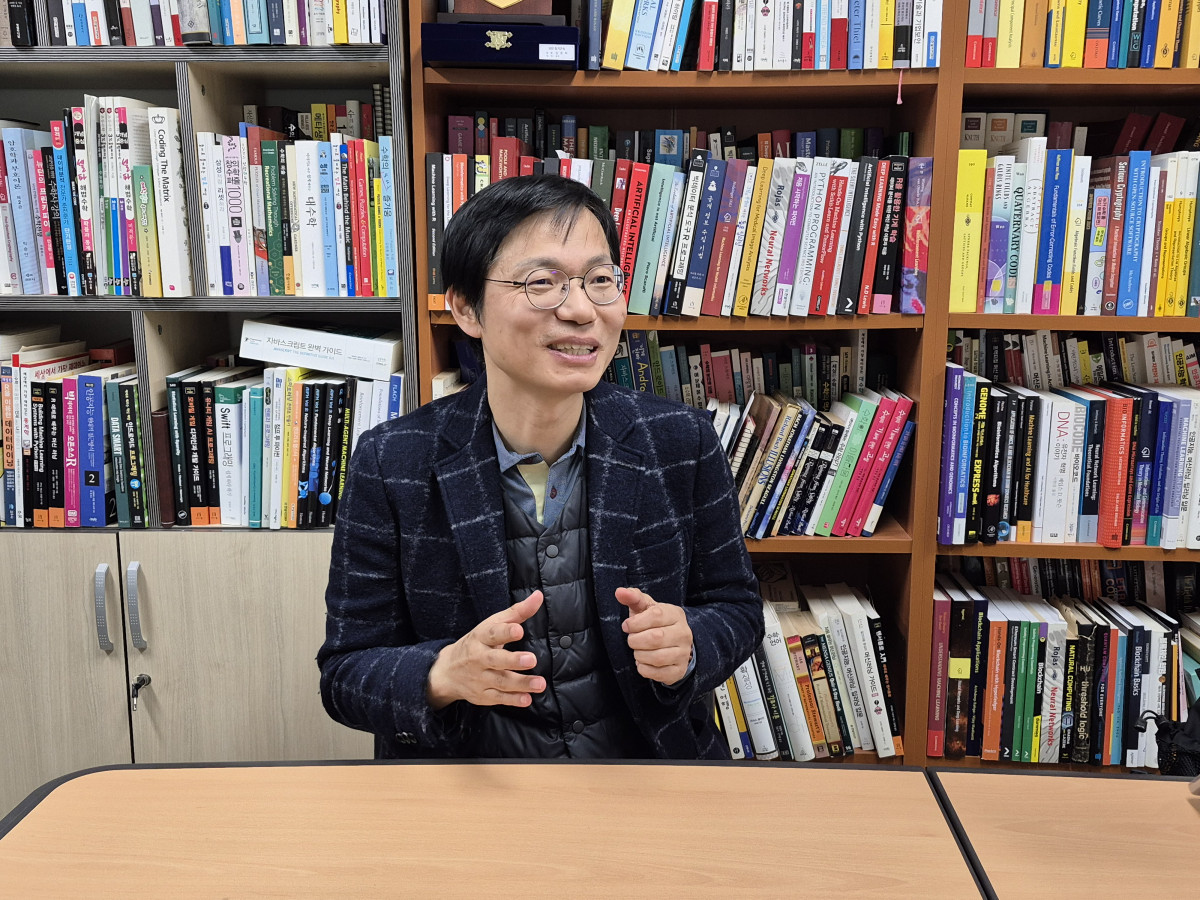

8일 서울 마포구 서강대학교 리치과학관 연구실에서 본지와 만난 김 교수는 “AI 환각 문제의 원인 중 하나는 잘못된 추론”이라며 “수리적 추론을 얼마나 정확하게 수행하는지가 신뢰할 수 있는 모델을 가르는 기준”이라고 말했다.

김 교수팀은 지난해 12월 15일 K-AI 주관사 5개 모델과 GPT·제미나이·딥시크 등 해외 5개 모델을 대상으로 수능 수학·논술 문제 평가 결과를 공개했다. 해외 모델들은 76~92점을 기록한 반면 국내 모델은 솔라 프로2가 58점을 받은 데 그쳤고 나머지 모델들은 20점대에 머물렀다.

김 교수가 국가대표 AI가 오픈소스로 공개되기 전 주관사들의 자체 AI 모델 검증에 나선 데에는 분명한 목적이 있다. 정부의 대규모 투자가 실제 AI 성능 향상으로 이어지고 있는지를 점검하기 위해서다. 단순한 순위 경쟁이 목표가 아닌 만큼 이번 평가에서는 상위 두 모델의 점수만 공개했다.

1차 평가와 비교하면 국내 모델의 성능 개선은 뚜렷하다. LG AI연구원의 수능 수학·논술 점수는 24점에서 70점으로 크게 올랐고 업스테이지는 60점에서 74점으로 향상됐다. 김 교수는 “이전 모델에 비해 국가대표 AI의 전반적인 성능이 높아졌다”며 “충분한 투자와 검증이 병행되면 우리나라 AI도 빠르게 따라잡을 수 있다는 신호”라고 평가했다.

김 교수팀의 목표는 단기 평가에 그치지 않는다. 김 교수는 “궁극적으로는 AI 성능을 검증하는 독립적 벤치마크를 만드는 것이 목표”라며 “한국의 ‘에포크 AI(Epoch AI)’가 되겠다”고 강조했다. 에포크 AI는 학습 데이터 규모와 연산 효율성, 기술 혁신성을 기준으로 전 세계 AI 모델을 엄격히 평가해 주목할 만한 모델 목록을 발표하는 미국 비영리 AI 연구기관이다.

발표 당시에는 수능 수학 문제에만 초점이 맞춰졌지만 실제로는 자체 문제 개발에 상당한 공을 들였다. 김 교수팀은 수학 올림피아드 수준과 대학·대학원 수준의 고난도 문제로 구성된 ‘엔트로피매스(EntropyMath)’ 100문제를 제작했고 이 중 10문항을 활용해 AI 성능을 평가했다.

연구팀에는 수학과와 데이터 사이언스 트랙 석·박사 과정생, AI 대학원 소속 연구원 등 10명이 참여하고 있다. 김 교수는 “공정한 평가는 정확한 문제 설계에서 출발한다”며 “AI 3대 강국 도약을 목표로 하는 우리나라에도 신뢰할 수 있는 비영리 AI 검증기관이 필요하다”고 말했다.

![[단독] AI로 금융사고 선제 차단… 금감원, 감독 방식 재설계 [금융감독 상시체제]](https://img.etoday.co.kr/crop/140/88/2279967.jpg)

![4인 가구 시대 저물고...경제 표준 된 ‘솔로 이코노미’[나혼산 1000만 시대]](https://img.etoday.co.kr/crop/140/88/2279978.jpg)

![두 번의 한중 정상회담이 남긴 과제⋯"실질적 협력 강화해야" [리셋 차이나]](https://img.etoday.co.kr/crop/140/88/2279982.jpg)

![[테슬라 vs 엔비디아 2부] 테슬라 FSD 독주 잡으려는 엔비디아 알파마요! 소름돋는 젠슨 황의 큰 그림 ㅣ 강정수 블루닷AI 연구센터장 [찐코노미]](https://i.ytimg.com/vi/uVdj1rA4yVc/mqdefault.jpg)

![라스베이거스 누빈 현대차 ‘로보택시’…좁은 골목길, 복잡한 교차로도 ‘척척’ [타보니]](https://img.etoday.co.kr/crop/85/60/2279593.jpg)

![“월급쟁이부자들, 부동산 중개 시장에 새 기준점 제시할 것”[인터뷰]](https://img.etoday.co.kr/crop/85/60/2279651.jpg)

![나홀로 북캉스·1인 다이닝...초개인화 맞춤서비스 부상[나혼산 1000만 시대]](https://img.etoday.co.kr/crop/85/60/2279371.jpg)

![‘1인용 회·1인 가전’ 등 소용량이 대세⋯달라진 소비재 시장[나혼산 1000만 시대]](https://img.etoday.co.kr/crop/85/60/2279968.jpg)

![4인 가구 시대 저물고...경제 표준 된 ‘솔로 이코노미’[나혼산 1000만 시대]](https://img.etoday.co.kr/crop/85/60/2279978.jpg)

![[인터뷰] 김종락 서강대 교수 “한국형 ‘에포크 AI’ 만들 것”](https://img.etoday.co.kr/crop/85/60/2279905.jpg)

![[이투PICK 순삭랭킹] 1월 둘째 주 유튜브 영상 순위](https://img.etoday.co.kr/crop/300/170/2278370.jpg)

![더불어민주당 새 원내사령탑에 3선 한병도 [포토]](https://img.etoday.co.kr/crop/300/190/2280004.jpg)