트레이니엄4 개발도 착수

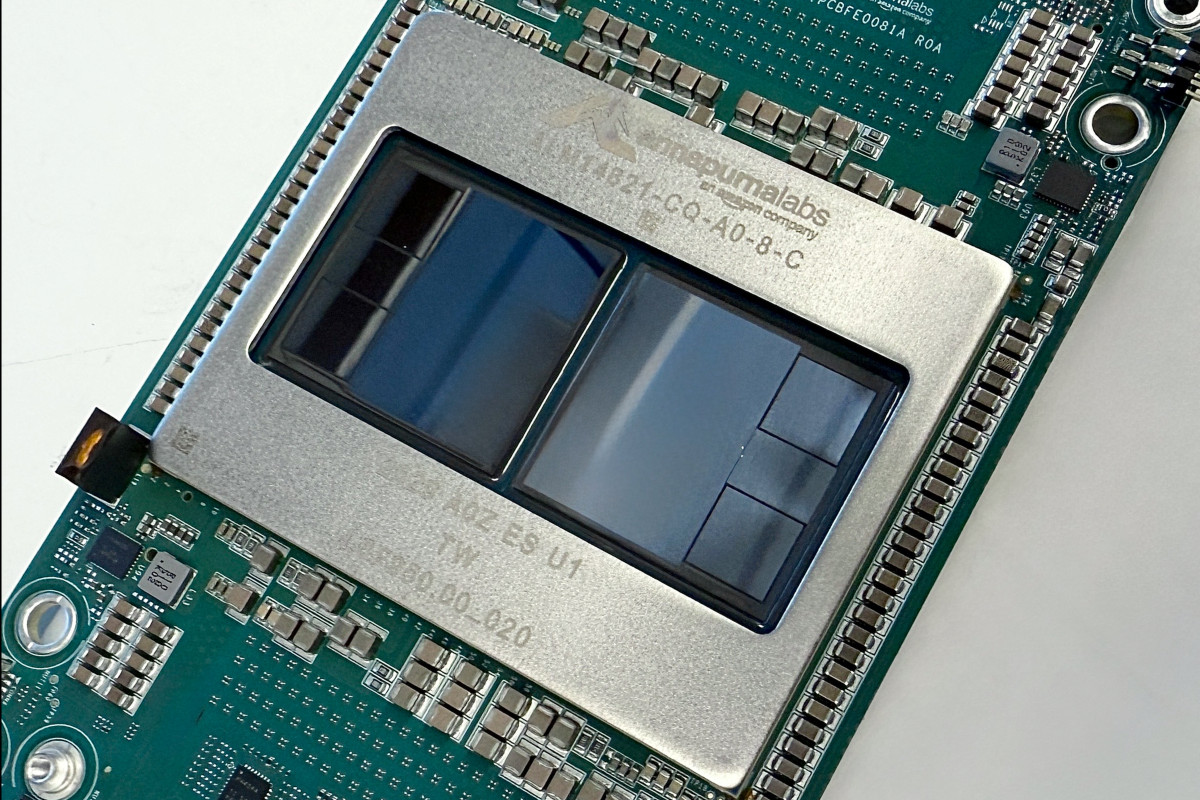

아마존이 2일(현지시간) ‘트레이니엄3’를 출시하며, 엔비디아와 구글에 맞선 최신 인공지능(AI) 칩 경쟁을 다시 본격화했다.

블룸버그통신에 따르면 아마존웹서비스(AWS)는 이날 미국 라스베이거스에서 개최한 연례 클라우드컴퓨팅 콘퍼런스 ‘리인벤트(re:Invent) 2025’에서 컴퓨팅 성능은 높고 전력 소모는 줄인 자체 칩 트레이니엄3를 출시한다고 발표했다.

전작인 트레이니엄2와 견줘 컴퓨팅 성능은 4배 이상으로 상향한 데 반해 에너지 소비량은 40%가량 낮췄다는 설명이다. AI 인프라의 병목으로 꼽히는 전력 소비를 줄여 이른바 전력 대비 성능비에 초점을 맞춘 것이 특징이다.

AWS는 엔비디아의 그래픽처리장치(GPU)와 비교해서는 AI 모델 훈련·운영 비용을 최대 50%까지 절감할 수 있다고 강조했다. 맷 가먼 AWS 최고경영자(CEO)는 “트레이니엄3는 대규모 AI 훈련과 추론 분야에서 업계 최고의 비용 효율성을 보인다”고 밝혔다.

AI 칩 시장에서 엔비디아가 80∼90% 점유율로 압도적인 1위를 구가하는 가운데 빅테크들은 전력 소비를 줄인 맞춤형 AI 칩을 앞다퉈 내놓으며 엔비디아에 도전장을 내밀고 있다는 분석이 나온다. 구글도 텐서처리장치(TPU)로 불리는 최신 AI 칩 ‘아이언우드’를 최근 출시하면서 높은 전력 효율성을 앞세웠다.

데이브 브라운 AWS 부사장은 “트레이니엄3가 최근 일부 데이터센터에 설치됐으며 이날부터 고객이 사용할 수 있게 된다”면서 “내년 초까지 매우 빠르게 규모를 확대할 것”이라고 밝혔다.

AWS는 불과 1년여 전 출시한 이전 버전 이후 바로 트레이니엄3를 공개한 것이다. 반도체업계에서는 이례적으로 빠른 속도로 평가한다. 지난해 8월 해당 칩을 처음 가동할 때 AWS 엔지니어는 “연기나 불꽃만 안 나면 좋겠다”고 농담하기도 했었다.

AWS는 또 트레이니엄3 대비 3배 이상의 성능의 후속 제품 ‘트레이니엄4’에 대한 개발도 이미 시작했다고 알렸다. 이는 매년 신제품 출시를 공언한 엔비디아의 속도와 보조를 맞추기 위함으로 풀이된다.

트레이니엄 칩의 상당수는 앤스로픽이 인디애나, 미시시피, 펜실베이니아의 데이터센터에서 사용하고 있다. AWS는 올해 초 50만 개 이상의 트레이니엄 칩을 앤스로픽의 최신 AI 모델 학습을 위해 제공했다고 밝혔으며, 연말까지 100만 개로 확대할 계획이다.

앤스로픽은 구글 TPU도 사용 중이며, 올해 초 구글과 수십억 달러 규모 컴퓨팅 파워 공급 계약도 체결했다.

AI 분야에서 차별화를 이루기 위한 아마존 전략에서 칩 개발은 핵심 요소다. AWS는 임대형컴퓨팅파워와 데이터 저장 서비스를 제공하는 세계 최대 업체지만, AI 도구를 개발하는 주요 기업들이 오픈AI와의 긴밀한 협력을 맺고 있는 마이크로소프트나 알파벳(구글)을 선택하는 경우가 많아, 그 우위를 동일하게 재현하는 데는 고전해왔다.

아울러 AWS는 이날 자체 AI 모델 노바의 새 버전 ‘노바2’와, 기업이 각자 자체 AI 모델을 만들 수 있도록 지원하는 ‘노바 포지’ 서비스도 선보였다. 트레이니엄과 마찬가지로 아마존은 ‘가격 대비 성능’을 무기로 내세우고 있다. 하지만 기존 노바 모델들은 AI 모델이 표준화된 질문에 어떻게 답변하는지 추적하는 벤치마크에서 업계 선두 주자로 평가받지 못했다.

아마존 AI 모델 개발을 총괄하는 로히트 프라사드 수석부사장은 “진짜 벤치마크는 현실 세계”라며 “새 모델이 경쟁력을 가질 것”이라고 말했다.

![달러가 움직이면 닭이 화내는 이유?…계란값이 알려준 진실 [에그리씽]](https://img.etoday.co.kr/crop/140/88/2182675.jpg)

![이재명 대통령 직무 긍정평가 62%…취임 6개월 차 역대 세 번째[한국갤럽]](https://img.etoday.co.kr/crop/140/88/2263961.jpg)

![머스크의 미친 설계 나온다! 내년 테슬라에 소름 돋는 일 벌어집니다 ㅣ 강정수 블루닷AI 연구센터장 [찐코노미]](https://i.ytimg.com/vi/52L5LlZpH8g/mqdefault.jpg)

![[오늘의 뉴욕증시 무버] 메타, 메타버스 예산 삭감 보도에 3%↑](https://img.etoday.co.kr/crop/85/60/2264265.jpg)

![[종합] 뉴욕증시, 금리인하 기대 속 혼조 마감…나스닥 0.22%↑](https://img.etoday.co.kr/crop/85/60/2264195.jpg)

![[상보] 국제유가, 러ㆍ우크라 종전 협상 교착…WTI 1.2%↑](https://img.etoday.co.kr/crop/85/60/2240039.jpg)

![달러가 움직이면 닭이 화내는 이유?…계란값이 알려준 진실 [에그리씽]](https://img.etoday.co.kr/crop/300/170/2182675.jpg)

![MAX얼라이언스-국민성장펀드 연계 간담회 [포토]](https://img.etoday.co.kr/crop/300/190/2264068.jpg)